SF映画で見たAIとの友情が、現実のものになる日は近いのかもしれません。

AI技術の進化はめざましく、今やスマートスピーカーやチャットボットは私たちの日常に溶け込んでいます。しかし、その先にあるのは単なる便利なツールではなく、心を通わせる相棒の誕生かもしれません。

本記事では、ヒューマンエージェントインタラクション(HAI)という分野で進む、人とエージェントの新しい関係性について紹介しています。

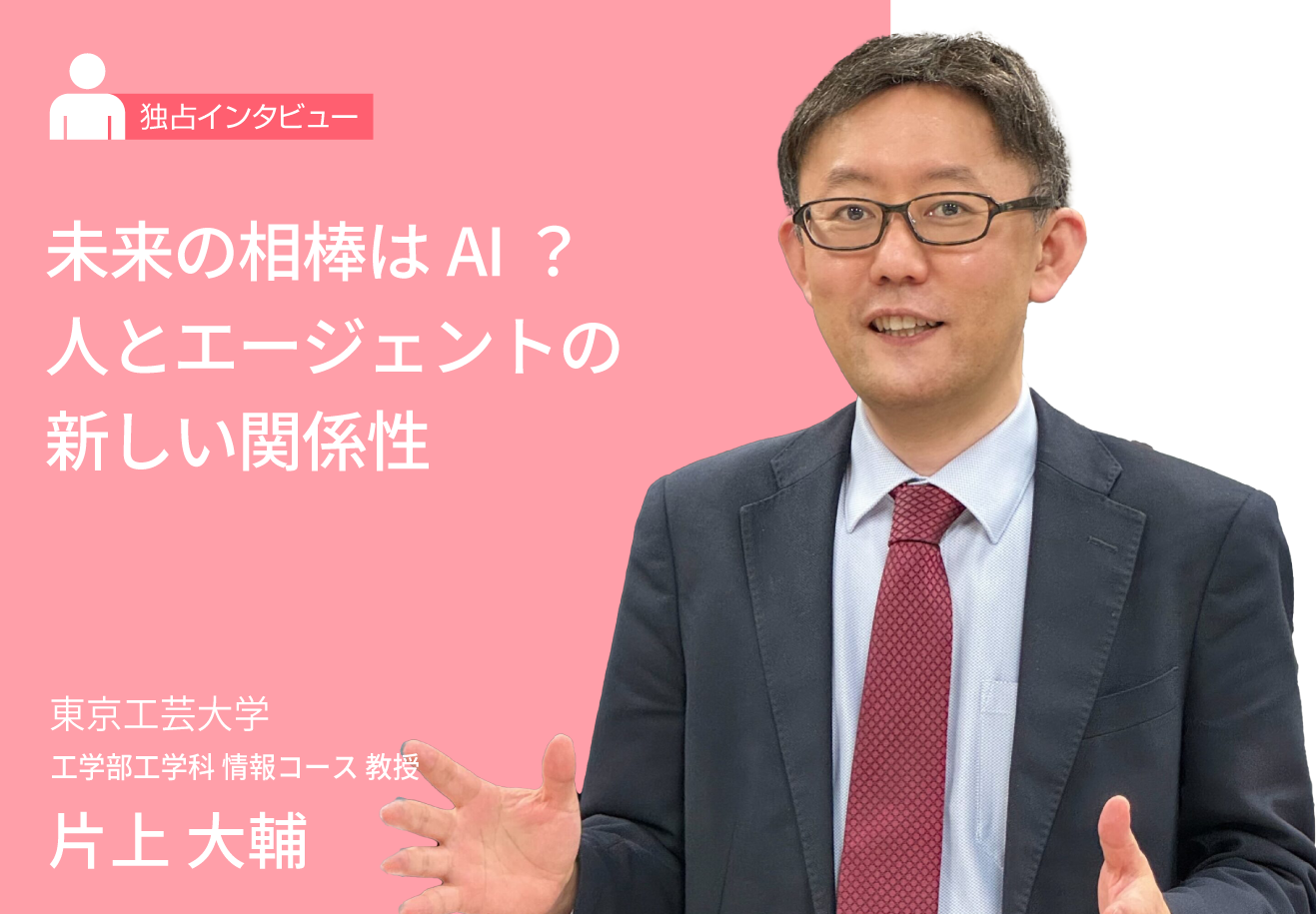

運転支援や介護支援、信頼できるエージェントの研究がどこまで進んでいるのか?AIを代表するエージェントとの未来の付き合い方が、私たちの暮らしにどんな影響を与えるのか?東京工芸大学の片上大輔教授に伺っています。

片上 大輔

東京工芸大学 工学部工学科 情報コース 教授

【biography】

2002年東京工業大学大学院総合理工学研究科知能システム科学専攻博士後期課程修了.博士(工学).同年東京工業大学大学院総合理工学研究科助手.2007年同大学同研究科助教.2010年東京工芸大学工学部コンピュータ応用学科准教授を経て,2017年教授.2020年同大学同学部工学科情報コース教授、現在に至る.ヒューマンーエージェントインタラクションに関する研究に従事し,近年は運転支援エージェント,対話システム、人狼知能,雰囲気工学に関する研究を行っている.IEEE,ACM,人工知能学会,日本知能情報ファジィ学会,ヒューマンインタフェース学会各会員.

HAI研究とは?人とエージェントの新たな関係性

ナレッジアート合同会社(以下KA):最初の質問として、先生が研究している分野について具体的に教えていただけますでしょうか。

片上氏:はい。ヒューマンエージェントインタラクション(HAI)という研究分野で研究をしております。この研究分野は、主に日本の研究者が立ち上げ、現在では国際会議も開催されるようになり、日本を中心に始まって世界へと展開しています。比較的、新しい研究分野だと考えています。

始まりは2006年の国内シンポジウム「HAIシンポジウム2006」です。特定の学会が主催するという形式や、特定の学会に所属する形ではなく、少し特殊な形で開催されました。2006年から継続して開催され、現在ちょうど19回目が終わったところです。約20年が経とうとしており、参加者数も増え、非常に活発な会議になっていると思います。

研究内容を説明しますと、言葉の通り、人間とエージェントの相互作用を研究する分野です。この文脈でのエージェントとは、擬人化エージェントやロボット、そして人間自身も含めて総称してエージェントと呼んでいます。そのエージェントと人間がどのようにインタラクション(相互作用)するかを研究しています。

主に、3つのインタラクションを対象としています。

- 人間と擬人化エージェントのインタラクション

- 人間とロボットのインタラクション

- エージェントを介した人間同士のインタラクション

これらのインタラクション自体を設計(デザイン)する研究分野だと理解していただければと思います。

具体的に説明しますと、2006年の第1回シンポジウムの挨拶で、運営委員長だった山田誠二先生や小野哲雄先生が、以下のような研究課題を挙げられています。

- 人間とエージェントが良好な関係を築く方法

- 人間がエージェントに飽きないようにする工夫

- 人間と協調作業するエージェントの実現可能性

- エージェントが人間に合わせるべきか、人間がエージェントに合わせるべきか

このような課題に対し、この分野は工学だけでなく、認知心理学、社会科学など様々な学問分野から研究者が集まり、学際的に課題解決に挑戦する新しい研究開発分野です。様々なバックグラウンドを持つ研究者が集まって研究を進めているのが特徴です。私の研究分野に関する説明は以上です。

運転支援、介護支援、そして信頼の構築

KA:ありがとうございます。先ほどの内容に対して1点追加で質問です。先生が今現在、最も力を入れている研究について具体的に教えていただけますか。

片上氏:はい。現在、特に力を入れている研究は3つあります。

1つ目は運転支援で、運転支援エージェントを開発しています。車内で隣にエージェントが同乗し、運転中に様々な対話を行うことで、運転操作のサポートだけでなく、雑談などを通じて精神的な面でも運転者を支える支援エージェントです。

例えば、人間が運転している際に、隣に同乗者がいると運転が穏やかになる現象が知られています。この現象は同乗者効果と呼ばれます。逆に、口うるさい同乗者だと運転が荒くなるという負の側面もありますが、全ての車にエージェントを搭載することは技術的に比較的容易なので、同乗者効果をうまく応用すると社会的効果は高いと思っています。

エージェントによって精神的なサポートができれば、世の中の運転が少し穏やかになり、交通事故が減って救われる命があるかもしれませんし、あおり運転のような問題がなくなる可能性もゼロではないと考えています。将来的なメリットを考慮しつつ、一緒にドライブするパートナーのような存在を開発する研究が1つ目です。

2つ目は医療支援関連の研究です。高齢化社会において認知症患者が増加し、その対策が問題となっています。特に問題となっているのが、認知症患者を介護する家族の負担であり、その家族介護者への支援が求められています。自分の家族が認知症になった際に初めて介護の現実に直面し、知識不足から一人で悩みを抱え込むケースが非常に多いと聞いています。現場では、外部には話しにくい悲惨な状況も存在すると言われています。

このような状況は、多くの場合、当事者になって初めて知るべきことに直面するために起こります。若いうちから認知症介護について学び、理解する機会が必要です。そこで、エージェント技術を利用して、若いうちに介護を疑似体験できるシステムを開発しています。特に、将来家族の介護を担う可能性のある若い世代に向けて、実際に介護者になる前に様々な体験をしてもらうことを目的としたシステム開発を行っています。

3つ目は、人間とエージェントの関係性です。HAI研究分野では多くのエージェントが提案されてきましたが、人間とエージェントの長期的な関係性を維持することは非常に難しい課題です。2006年のシンポジウムでも「人間がエージェントに飽きないようにするにはどうすれば良いか」という課題が挙げられていましたが、人間はエージェントにすぐに飽きてしまいます。人間同士の関係では予期しない出来事が起こるため飽きにくいかもしれませんが、長期的な信頼関係を築くことは非常に困難です。

エージェントやソフトウェアは、最初は面白く感じても、ある程度インタラクションを続けると、想定の範囲内の応答に飽きてしまいます。ゲームに飽きる感覚と近いかもしれません。そのため、長期的な信頼関係を結べる「相棒」や「パートナー」のようなシステムを構築することは非常に難しい課題です。

先日開催された2025年5月の人工知能学会全国大会では、約4800人が大阪に集まりました。その基調講演で人工知能学会会長が「AIバディを作る」という話をされていました。バディを作るには信頼性が非常に重要であり、長期的な信頼性をいかに構築するかは、やろうとしてもなかなかできない難しい課題でもあります。実験自体も長期間に及ぶため困難が伴いますが、研究テーマとしては非常に面白いと考えており、時間はかかるかもしれませんが、良い研究テーマとして継続していきたいと考えています。最近は、この3つのテーマに特に力を入れて研究活動を行っています。

進化と倫理 HAI分野が直面する課題と展望

KA:では次に、HAI分野における現状の課題と、その課題に対する改善策があれば教えていただきたいです。

片上氏:まず、先ほど述べた長期的な信頼性の確保は1つの課題と言えるでしょう。

また、現在気になっているのは、生成AI、特に大規模言語モデル(LLM)の活用です。LLMが急速に発展し、状況はものすごい勢いで変化しています。インタラクション研究においても、LLMの活用が急速に進んでおり、例えば雑談システムが容易に作れるようになるなど、できることが格段に増えています。LLMの活用自体は、非常に良いことであり、これまで不可能だったことが可能になり、新しい世界が見えてくることで、今後も数多くのブレイクスルーが生まれると期待しています。

一方で、多くの研究がLLMに偏ってしまう状況は望ましくないと考えています。その是非についても検討が必要です。研究の多様性を保ち、裾野の広いコミュニティであり続けることが重要だと考えています。

例えば、人工知能学会では、ディープラーニングがブームになった第3次人工知能ブームの際、機械学習の研究が著しく増加しました。ウェブが流行した時代にはウェブインテリジェンスの研究が発表の大半を占めたこともありました。

ブームの時期には深層学習が多用されましたが、学会としては他のAI分野の研究も継続して行うことの重要性を認識していました。同様に、HAI研究分野においても、全員が同じ方向を向きすぎるのではなく、幅広く多様な研究が進展することが望ましいと個人的には考えています。これが一つの課題と言えるでしょう。

この内容に関して、私自身もLLMを使って調査を行いましたが、課題は多岐にわたります。例えば、エージェントの信頼性、倫理、公平性の問題は、国際会議HAIでも頻繁にテーマとして取り上げられています。昨年の国際会議の基調講演では、「信頼性のあるヒューマンロボットインタラクション」がテーマになりました。信頼や道徳的判断が重要なテーマとなっています。

また、公平性やバイアスへの取り組みも行われています。2023年の国際会議では、チャットボットやロボットにおけるプライバシー保護の研究がセッションで扱われました。例えば、チャットボットが過去の会話内容を記憶し、他の人に話してしまうような状況は望ましくありません。プライバシーの問題や、透明性、ユーザーの信頼確保も問題視されています。

生成AIやLLMの積極的な活用と並行して、信頼性、倫理、公平性といったキーワードが、注意すべき点として挙げられます。

その他の課題としては、LLMをリアルタイムの人間とのインタラクションに応用する場合、軽量化や最適化といった技術的な工夫が求められます。また、評価手法も確立されていません。エージェントの自然さや利便性などをどのように評価していくか、様々な指標が用いられていますが、統一的な評価手法の確立が必要になってくるでしょう。

LLMはHAI研究にどう活きる?

KA:話の中でLLMという言葉が出てきましたが、現在、AIではチャットGPTが主流だと思います。チャットGPTとLLMを比較した場合、どのような場面でLLMを活用すべきか、その具体的な使い道を教えていただけますか。

片上氏:はい。LLMは非常に多様な用途に利用できます。チャットGPTは基本的にLLMを基盤として動作しています。私はLLMの専門家ではないので、表現が正確でないかもしれませんが、使い方としては、チャットGPTのように自然言語で問い合わせることで、人間のように回答を得ることができます。これは、ウェブ上などの膨大なデータから学習し、適切に応答するシステムです。

これが基本的な使い方ですが、プロンプトエンジニアリングという手法を用いて、指示(プロンプト)を工夫することで、非常に多様なタスクを実行させることができます。例えば、ロボットの制御コマンドをLLMに生成させたり、プログラムを作成させたり、議事録を作成させたり、長文を要約させたり、もちろん翻訳も可能です。非常に多くのことが短時間で実行できるのが技術的な革新であり、応用範囲が広いため、アイデア次第で様々なことが実現可能です。

エージェントのインタラクションを考える上では、人間と同じような自然な雑談ができるようになります。プロンプトの書き方次第で、いかようにも応用できます。現在、多くの企業が様々な種類のLLMモデルを開発し、しのぎを削っているため、性能は向上し続けています。それぞれのモデルに特徴があり、応用研究が盛んに進んでいます。特にHAI分野はLLMとの相性が良いため、LLMを活用した研究が数多く行われ始めています。

HAIが描く未来のインタラクション

KA:では、HAI分野における今後の展望について教えていただけますでしょうか。

片上氏:はい。今後の展望ですが、先ほどの話と関連しますが、大規模言語モデルを活用することで、これまで実現が難しかった新しいインタラクションや世界観を創出できると考えています。それによって、人間とエージェントの関係性も変化していくでしょう。関係性をどのように変えていけるかが、今後の大きな期待です。人間とシステムという単純な関係ではなくなっていくでしょう。

特に、人間が持つ「愛」「信頼」「裏切り」「共感」「協調」「駆け引き」といった感情や行動、そして先ほど話に出た長期的な関係性や、日本人で言う「おもてなし」のような、より高度な社会的配慮を含む、人間の根源的で日常的なインタラクションが、どこまで実現可能かという点に、個人的には非常に興味を持って注目しています。

これらの要素は、従来AIでの実現が非常に難しいとされてきた分野でしたが、技術の進歩によって実現の可能性が見えてきています。もちろん、挙げた要素の中には、従来の人工知能で部分的に実現できていたものもありますが、LLMによって格段に実現しやすくなっていると感じます。個人的には非常に前向きに捉えており、新しい世界を創造できるという大きな期待を持っています。

SFの世界をその手で創る

KA:それでは、最後に読者の方々に対してのメッセージをお願いします。HAI分野で研究に携わっている方や、今後そのような仕事を検討している方へのアドバイスをお願いできますでしょうか。

片上氏:はい。日本において、日本の研究者が中心となってHAI分野が立ち上がり、先ほどお話ししたように、来年でちょうど20年になります。この間、HAI分野の研究が進み、多くの研究者が生まれ、企業へ就職する人も増え続けています。

ディープラーニングから始まった第3次人工知能ブームを経て、現在は生成AIや大規模言語モデルが時代を席巻しています。今後は、AIエージェントやインタラクションが中心となる時代に移行しつつあると個人的に考えています。このような最新の研究に触れ、これまでSFやアニメの世界で描かれてきたような新たな世界を、各研究者が自ら作り上げることによって、未来は明るくなると信じています。

国内会議のHAIシンポジウムは、コロナ禍でもオンラインで開催されるなど、19年間毎年続いてきました。毎年100人から200人ほどの参加者が集まり、延べ約3000人が参加し、独創的で楽しい議論を尽くしてきました。新しい世界を創造する、非常に面白い研究分野だと思っています。

HAI分野の研究や仕事を検討している方々へのメッセージですが、ぜひ皆さんに参加していただき、一緒に活動できることを嬉しく思います。多くの方々が集まり、それぞれのアイデアについて、ぜひ一緒に議論できたらと願っています。